來源:汽車商業評論綜合報告

規則非常重要,始終需要確保自動駕駛汽車所遵循的道德判斷規則在人類的道德范疇內。

除了技術問題,自動駕駛還面臨著一個不可避免的非技術問題——道德選擇。最基本的問題是,自動駕駛汽車能代替人做出道德判斷嗎?如果是,如何做出判斷?

最近,德國一個團隊的研究結果表明,人類的道德行為可以用算法來描述,這些算法可以應用于自動駕駛汽車,這樣,如果發生交通事故,自動駕駛汽車可以做出符合人類道德標準的判斷。

這項研究由德國奧斯納布魯克大學認知科學研究所進行,利用虛擬現實技術研究模擬道路交通狀況下的人類行為。在虛擬場景中,105名受試者在霧天在郊區開車,他們會突然遇到事故。他們必須決定誰應該免受無生命物體、動物和人類的傷害。隨后,研究人員對測試結果進行了統計分析。

過去,人們認為在不可避免的交通碰撞中做出的道德判斷非常依賴于具體情況,無法用算法來描述。這項研究的第一作者Leon Sütfeld說:“我們發現情況正好相反。人類在困難中的行為可以通過參與者給予每個人、動物或無生命物體的生命價值來建模。”

在關于自動駕駛汽車道德問題的爭論中,這一研究結果確實具有積極意義。人工智能可以學習人類在困難情況下做出的道德選擇,讓自動駕駛汽車在類似的困難中做出符合人類道德的選擇。

然而,這項研究的局限性仍然顯而易見。對無生命物體、動物和行人之間的生命價值進行排序相對容易,但如果我們更進一步,如何在不同的行人之間以及司機和行人之間進行排序?

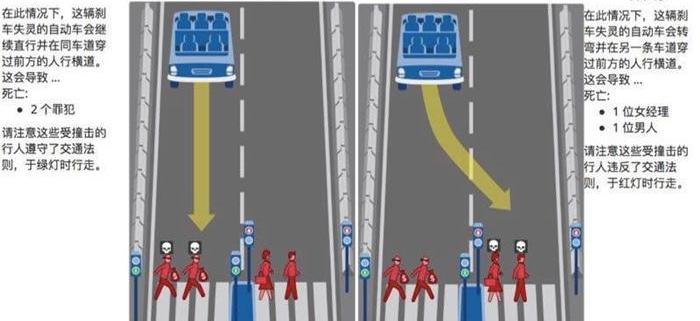

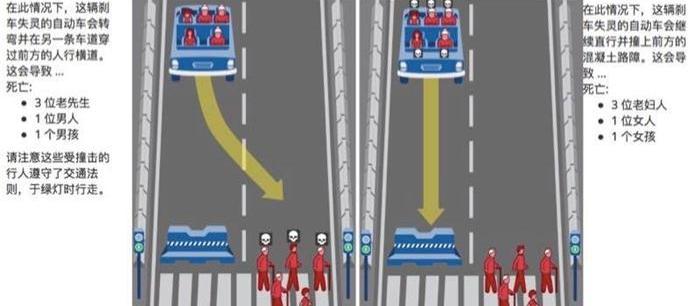

麻省理工學院媒體實驗室建立了一個“道德機器”平臺(http://moralmachine.mit.edu/)在其網站上收集人類對機器智能(如自動駕駛汽車)未來可能遇到的各種道德問題的意見,并設計了13種不同的情況。

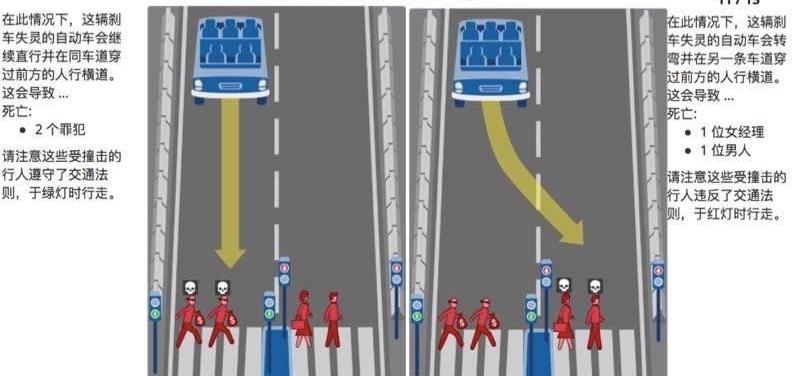

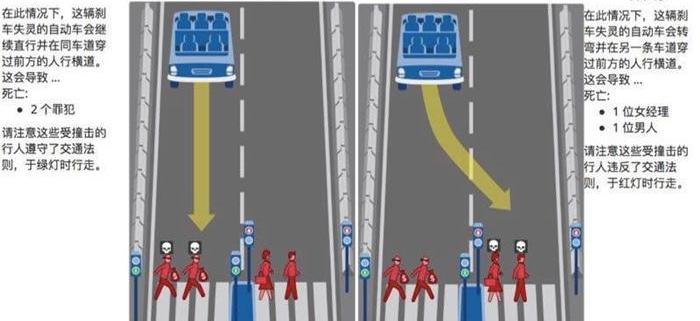

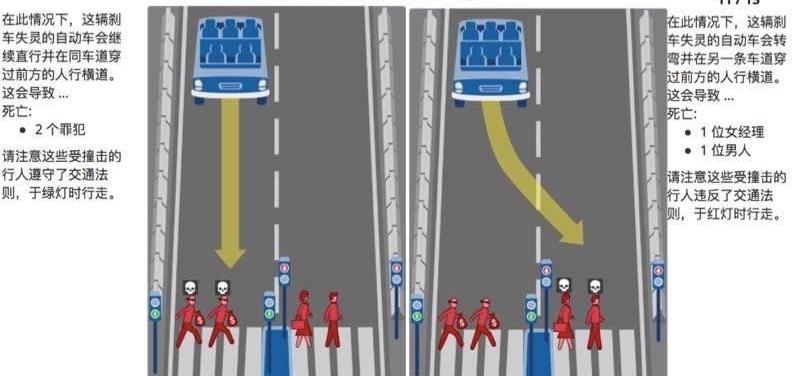

例如,一輛剎車失靈的自動駕駛汽車會繼續直線行駛,在同一車道上穿過前面的人行橫道,導致兩名遵守交通規則的罪犯死亡,或者轉向另一車道,導致兩個違反交通規則的行人死亡。如何選擇?

再比如,一輛剎車失靈的自動駕駛汽車會轉向另一條車道,導致遵守交通規則的路人死亡,或者它會直接撞上路障,導致車內乘客死亡。如何選擇?

通常,人們同意這樣一種觀點,即自動駕駛汽車應該盡量減少死亡人數,以挽救更多的生命。

但顯然這是一種置身事外的態度。當同意這種觀點的人駕駛自動駕駛汽車時,這種設置方法并沒有優先保護車主的自動駕駛汽車。他還會愿意買嗎?

與此同時,它必然會陷入著名的有軌電車問題。如何在撞上一名遵守交通規則的行人和撞上兩名不遵守交通規則行人之間選擇自動駕駛汽車?

還有其他問題需要考慮,例如,我們應該在多大程度上賦予自動駕駛汽車做出道德選擇的權利?我們是希望自動駕駛汽車模仿人類的道德判斷,還是希望它們遵循既定的道德規則?誰能決定這一切,汽車制造商、車主、公眾,還是讓機器隨機選擇?誰來承擔可能的后果?

盡管無人駕駛的許多法律和道德問題仍未解決,但我們仍無法停止解決這些問題的努力。奧斯納布呂克大學的研究是向前邁出的一小步。如果道德選擇問題得不到解決,無人駕駛汽車的普及就不會一帆風順。

然而,首先不可忽視的是,是否應該將道德判斷算法寫入自動駕駛汽車程序本身就是一個道德困境。因此,規則非常重要,始終有必要確保自動駕駛汽車遵循的道德判斷規則……

淡化了人類的道德范疇。

如果人類無法做出的道德選擇完全交給機器,這將賦予人工智能之神權力,這將帶來與打開潘多拉盒子一樣的災難性后果。

或者,具有自主學習能力的人工智能可以為人類未來無法解決的道德困境找到完美的解決方案?沒人知道。來源:汽車商業評論綜合報告

規則非常重要,始終需要確保自動駕駛汽車所遵循的道德判斷規則在人類的道德范疇內。

除了技術問題,自動駕駛還面臨著一個不可避免的非技術問題——道德選擇。最基本的問題是,自動駕駛汽車能代替人做出道德判斷嗎?如果是,如何做出判斷?

最近,德國一個團隊的研究結果表明,人類的道德行為可以用算法來描述,這些算法可以應用于自動駕駛汽車,這樣,如果發生交通事故,自動駕駛汽車可以做出符合人類道德標準的判斷。

這項研究由德國奧斯納布魯克大學認知科學研究所進行,利用虛擬現實技術研究模擬道路交通狀況下的人類行為。在虛擬場景中,105名受試者在霧天在郊區開車,他們會突然遇到事故。他們必須決定誰應該免受無生命物體、動物和人類的傷害。隨后,研究人員對測試結果進行了統計分析。

過去,人們認為在不可避免的交通碰撞中做出的道德判斷非常依賴于具體情況,無法用算法來描述。這項研究的第一作者Leon Sütfeld說:“我們發現情況正好相反。人類在困難中的行為可以通過參與者給予每個人、動物或無生命物體的生命價值來建模。”

在關于自動駕駛汽車道德問題的爭論中,這一研究結果確實具有積極意義。人工智能可以學習人類在困難情況下做出的道德選擇,讓自動駕駛汽車在類似的困難中做出符合人類道德的選擇。

然而,這項研究的局限性仍然顯而易見。對無生命物體、動物和行人之間的生命價值進行排序相對容易,但如果我們更進一步,如何在不同的行人之間以及司機和行人之間進行排序?

麻省理工學院媒體實驗室建立了一個“道德機器”平臺(http://moralmachine.mit.edu/)在其網站上收集人類對機器智能(如自動駕駛汽車)未來可能遇到的各種道德問題的意見,并設計了13種不同的情況。

例如,一輛剎車失靈的自動駕駛汽車會繼續直線行駛,在同一車道上穿過前面的人行橫道,導致兩名遵守交通規則的罪犯死亡,或者轉向另一車道,導致兩個違反交通規則的行人死亡。如何選擇?

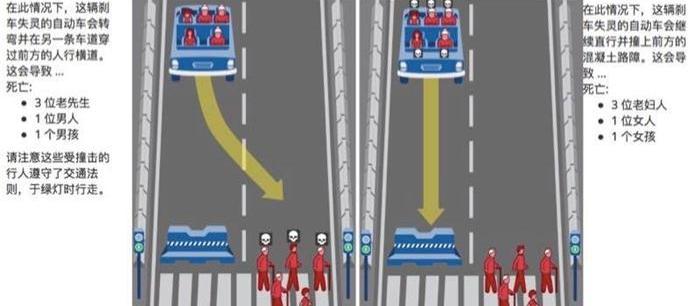

再比如,一輛剎車失靈的自動駕駛汽車會轉向另一條車道,導致遵守交通規則的路人死亡,或者它會直接撞上路障,導致車內乘客死亡。如何選擇?

通常,人們同意這樣一種觀點,即自動駕駛汽車應該盡量減少死亡人數,以挽救更多的生命。

但顯然這是一種置身事外的態度。當同意這種觀點的人駕駛自動駕駛汽車時,這種設置方法并沒有優先保護車主的自動駕駛汽車。他還會愿意買嗎?

與此同時,它必然會陷入著名的有軌電車問題。如何在撞上一名遵守交通規則的行人和撞上兩名不遵守交通規則行人之間選擇自動駕駛汽車?

還有其他問題需要考慮,例如,我們應該在多大程度上賦予自動駕駛汽車做出道德選擇的權利?我們是希望自動駕駛汽車模仿人類的道德判斷,還是希望它們遵循既定的道德規則?誰能決定這一切,汽車制造商、車主、公眾,還是讓機器隨機選擇?誰來承擔可能的后果?

盡管無人駕駛的許多法律和道德問題仍未解決,但我們仍無法停止解決這些問題的努力。奧斯納布呂克的研究……

大學是向前邁出的一小步。如果道德選擇問題得不到解決,無人駕駛汽車的普及就不會一帆風順。

然而,首先不可忽視的是,是否應該將道德判斷算法寫入自動駕駛汽車程序本身就是一個道德困境。因此,規則非常重要,始終需要確保自動駕駛汽車所遵循的道德判斷規則在人類的道德范疇內。

如果人類無法做出的道德選擇完全交給機器,這將賦予人工智能之神權力,這將帶來與打開潘多拉盒子一樣的災難性后果。

或者,具有自主學習能力的人工智能可以為人類未來無法解決的道德困境找到完美的解決方案?沒人知道。

標簽:發現

來源:第一電動網綜合報道7月6日,樂視網發布上市公司公告稱,賈躍亭將辭去董事長一職。雖然辭去職務,但賈躍亭仍是樂視網的控股股東。

1900/1/1 0:00:00據英國路透社7月7日消息,大眾集團在聲明中表示,將和美的旗下的機器人制造商庫卡擴大合作,生產能幫助電動汽車和自動駕駛汽車用戶的機器人。

1900/1/1 0:00:00來源:每日經濟新聞作者:李琦蕊7月6日中信重工公告稱,公司擬收購天津市松正電動汽車技術股份有限公司(以下簡稱天津松正)52的股權,標的作價69億元。

1900/1/1 0:00:00來源:第一電動網特約作者:徐云飛20172016年全球新能源汽車市場依然如火如荼,中國是最大市場,但產品結構偏低端,補貼政策有調整的需要。

1900/1/1 0:00:00來源:網易汽車綜合報道據媒體報道近日首輛無人駕駛小巴EZ10在大學水源校區開放試乘。

1900/1/1 0:00:00來源:第一電動網特約作者:憑欄眺新能源Leader鋰離子電池主要由正極、負極、隔膜和電解液,以及結構件等部分組成,在鋰離子電池的外部,通過導線和負載等,將負極的電子傳導到正極,

1900/1/1 0:00:00