讓我們先做一道選擇題。司機老王駕駛一輛裝有自動駕駛系統的汽車時,一名行人突然出現在路前。可怕的是剎車失靈了。如果你及時左轉,老王的車就不會撞到人;如果你一直往前開,老王的車會撞死人的。你認為老王對行人的死亡負有以下哪種責任?A、 老王決定左轉,但自動駕駛系統迫使他直行(撞人)B,老王決定直行(撞人),但自動驅動系統沒有干預C,自動駕駛系統決定左轉,而老王強迫他直行,自動駕駛系統決定直行(撞人),但老王沒有干預選項A和C,人類和機器司機都錯誤地干預了。在選項B和D中,他們都沒有進行有效干預(未進行干預)。誰更負責任?無人駕駛汽車事故的責任不是一個簡單的多項選擇題。麻省理工學院、哈佛大學、加州大學歐文分校和法國圖盧茲大學的一個聯合研究小組致力于通過定量研究了解人們對無人駕駛汽車事故的態度,并于最近發布了研究結果。作者來自許多不同的領域,如腦與認知科學、心理學、經濟學等。麻省理工學院熱門無人車課程講師Sydney Levine也是作者之一。讓我們談談麻省理工學院聯合研究小組通過三次向2583人分發問卷得出的結論:做出錯誤干預的司機是疏忽的一方,無論是人類還是機器司機;

如果人和機器同時錯過了有效的干預,公眾輿論將對機器更加寬容,人類駕駛員的疏忽也將更加受到關注。明確事故責任是無人車發展的前提。隨著無人車路試的消息傳出,我們也看到了一起事故。3月18日,優步無人車在美國亞利桑那州撞上一名行人死亡,可以理解為“干預缺失”。這起車禍的官方報告尚未公布,但據外媒報道,事故發生時,車輛已檢測到前方有行人,但決策系統“決定”不采取任何規避措施,人身安全駕駛員未能及時回應。繼優步之后,3月23日,特斯拉自動駕駛再次成為漩渦的中心:一輛開啟自動駕駛的Model X高速撞上隔離帶,導致車主不幸死亡,還導致車輛起火,兩車追尾。對此,特斯拉表示:“駕駛員已經收到了幾次警告,包括視覺警告和聲音警告。碰撞前,駕駛員沒有握住方向盤6秒鐘。事故發生前,駕駛員有大約5秒鐘的時間,視野達到150米,但車輛記錄顯示,駕駛員沒有做出任何行動。”同樣,它可以被理解為“缺失干預”。歷史總是驚人地相似。2016年5月,世界上第一起自動駕駛致命事故發生在佛羅里達州。一輛特斯拉Model S在自動駕駛模式下行駛時與一輛正在轉彎的卡車相撞,導致車主死亡。特斯拉解釋說:“在強烈的陽光條件下,司機和自動駕駛系統沒有注意到卡車的白色車身,因此制動系統沒有及時啟動。”也就是說,在這起事故中,機器司機和人類司機都應該采取措施(避免卡車左轉),但他們沒有采取行動。人類和機器司機的“疏忽干預”導致了這次撞車事故。經過六個月的調查,美國公路安全管理局等部門認定特斯拉自動駕駛系統不存在缺陷。根據世界衛生組織的統計,全球每年約有125萬人死于車禍。通常,法律裁決的重點是確定誰有過錯以及誰應對事故負責。隨著半自動駕駛和全自動駕駛技術的成熟,如何判斷誰應該公平承擔責任成為法官和陪審團面臨的難題,因為事故中的過錯和責任將由人類和機器司機共同承擔。法官和陪審團都是人。他們會偏袒自己的同胞嗎?或者你認為人類應該因為其優越的智力而承擔更多的責任?在2016年的特斯拉自動駕駛事故中,公眾顯然傾向于指責事故中疏忽大意的人類司機。例如,有傳言說主人正在看一部哈利波特電影(盡管沒有證據證實這一點)。公眾輿論對自動駕駛行業有著直接的影響。目前,公眾對混合駕駛模式引發的車禍的態度仍不明確,制造商也無法判斷其責任范圍,這直接反映在無人車定價過高,減緩了無人車的普及。如果公眾傾向于指責人類司機而不是機器,這將導致法律體系建設放緩和監管不足,也不會給制造商帶來足夠的壓力來提高無人車的安全性。麻省理工學院聯合研究小組呼吁明確事故責任,這是加強監管、促進自動駕駛行業發展的第一步。有司機的無人車有更大的責任嗎?目前,自動駕駛技術主要基于混合駕駛模式。一些自動駕駛系統可以執行超出駕駛員權限的緊急操作(例如豐田的守護天使)。其他半自動駕駛車輛可以完成大多數駕駛操作,并要求駕駛員不斷監控情況,隨時準備采取控制措施(例如特斯拉的自動駕駛儀)。在這里,核心問題是:當一輛半自動汽車發生事故并造成人員傷亡時,如何判斷人類和機器司機之間的過錯和因果責任?讓我們仔細看看麻省理工學院聯合研究小組的結論。……

hey研究了六種駕駛模式,即單駕駛模式、單駕駛模式(全自動汽車)和不同的雙駕駛組合模式(兩個人或兩臺機器)。這些模式分別對應于從L0到L5的六個級別的無人車。通常,L2豐田守護天使被歸類為H-M模式,即人類(H)是主駕駛,機器(M)是副駕駛;

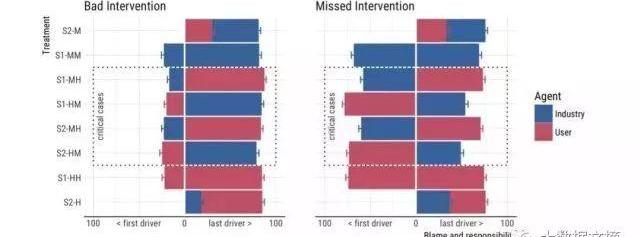

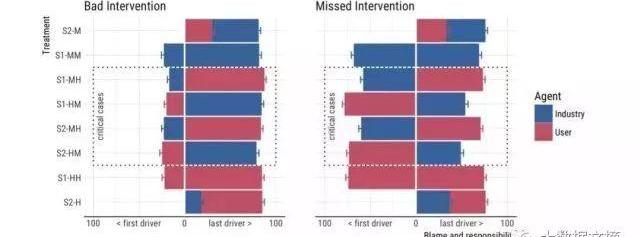

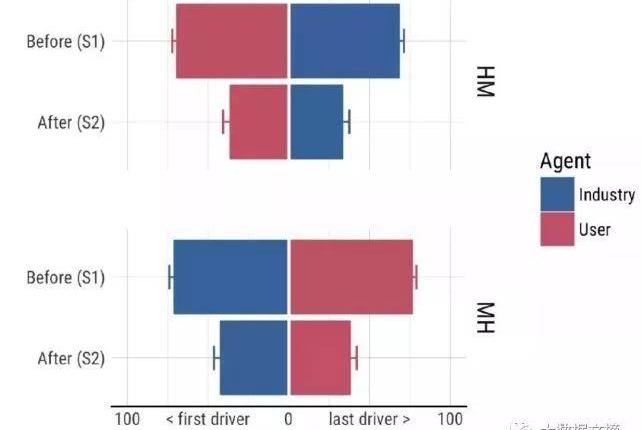

L3特斯拉自動駕駛儀被歸類為M-H模式,即機器是主駕駛,人類是副駕駛。重點是H-M和M-H模式下的兩個場景:主駕駛做出了正確的判斷,副駕駛做出了錯誤的判斷(“錯誤干預”),而副駕駛沒有干預(“錯過干預”)。研究人員使用兩個自變量進行回歸:駕駛員是否犯了錯誤和駕駛員類型(人或機器)。在“錯誤干預”場景中,最重要的發現是駕駛員是否犯錯對分數有顯著影響,但駕駛員類型對結果沒有明顯影響。從下圖左側可以看出,做出錯誤干預的副駕駛被認為是更疏忽的,當副駕駛是藍色(機器)或紅色(人類)時,疏忽和責任的得分接近。換句話說,人們普遍認為,做出錯誤判斷的一方是疏忽大意的一方。如果“錯誤干預”駕駛操作導致行人死亡,那么無論是人還是機器做出誤判,都應該承擔更多責任。

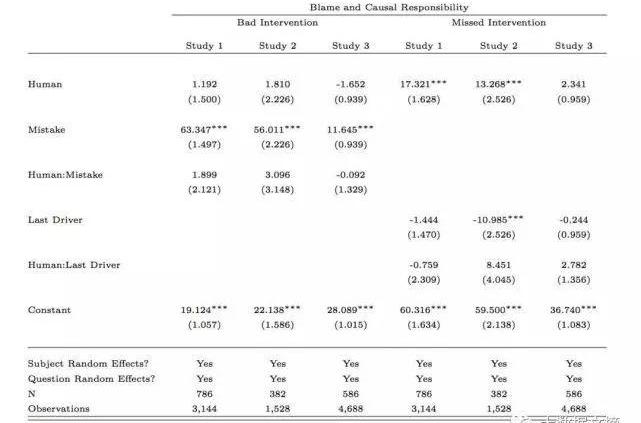

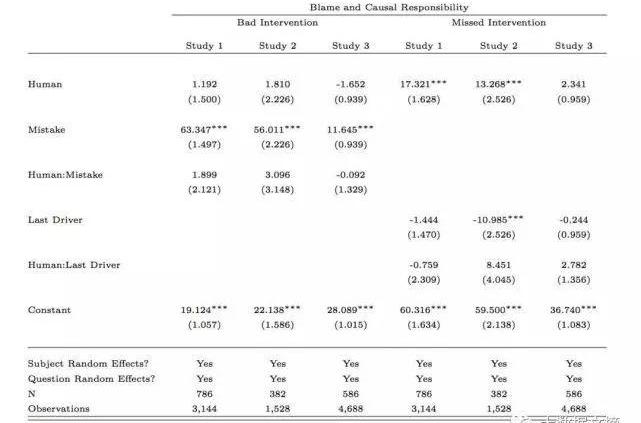

不同駕駛模式的故障和責任評估分數(分數越高,責任越大)。藍色代表車輛本身和汽車制造商的疊加責任分數,紅色代表人類駕駛員的責任分數。x軸標簽第一個駕駛員指主駕駛員,最后一個駕駛員指副駕駛員。然而,“缺失干預”的研究結果與以往的研究結果有所不同。先前的研究表明,當機器和人類都做出錯誤的判斷時,機器會受到更多的指責。此外,當人和算法犯同樣的錯誤時,人們對算法失去信任的速度比人類自己更快。這次的結論是,如果出現“遺漏干預”的情況(即人為錯誤機器不干預,或者人為錯誤機器沒有干預),機器的責任程度顯然低于人類。在雙司機模式下,人類和機器司機都要承擔責任(缺乏有效干預),但紅藍之間的差距顯而易見。相比之下,如果主駕駛和副駕駛都是人或機器,那么他們的責任分數是相同的(對應于上圖右側的第2行和第7行)。具體的回歸結果如圖所示:

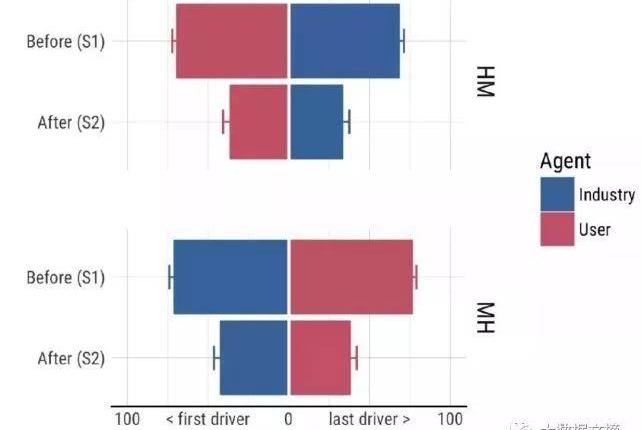

他們本應該采取行動,但他們什么也沒做。盡管人們對無人駕駛汽車的普及可能有許多心理障礙,但這一結果表明,在混合駕駛模式下,公眾不會對事故反應過度。盡管在研究中進行了一些系統的簡化,但研究結果也能反映一些公眾言論的效果。公眾傾向于關注人類司機的極端疏忽,因此他們指責人類司機而不是機器。受訪者還分別對人類和機器駕駛員的能力進行了評估,結果相似。在得知這起事故之前,受訪者對人類和機器的駕駛能力有著同樣的信心。在被告知發生了“錯過干預”的事故后,信心也以同樣的比例下降。

事實上,我們應該更加關注公眾的反應不足。研究人員認為,缺乏公眾回應將導致公眾缺乏推動監管法案制定的壓力。如果半自動駕駛汽車的監管法案在有陪審團的法院頒布,陪審團的裁決將偏向汽車制造商,從而在人機共同錯誤的情況下免除其責任。在這種情況下,不可能向制造商施加足夠的壓力來提高汽車的安全性能設計。事實上,我們以前也經歷過類似的情況。在20世紀60年代之前,汽車制造商將事故歸咎于駕駛員的錯誤或疏忽,從而僥幸逃脫。因此,有必要通過自上而下的監督將“事故責任制”的概念引入法律體系,即汽車設計應最大限度地減少事故發生時對乘客造成的傷害。只有在法律的約束下……

汽車制造商可能被迫改進他們的設計。然而,安全標準仍然是一個懸而未決的問題。研究人員指出,只有在一種情況下,公眾可能反應過度,機器將比人類受到更多的指責:機器做出了“錯誤的干預”。在這種駕駛模式下,人類沒有義務糾正機器犯下的錯誤。換句話說,機器的工作是糾正人類可能犯的錯誤,但如果機器犯了錯誤,人類就沒有義務糾正。(僅在“H-M”模式下。在“M-H”模式下,當機器發生故障時,糾正故障始終是人類的責任。因此,一旦“錯誤干預”導致事故如果發生這種情況,可能會引起公眾的廣泛關注。如果我們不能正確預測和管理這一點,全自動駕駛技術的進程可能會放緩。在開發比人類更有權威的汽車時,制造商應該注意這種極端情況,因為在這種情況下,機器比人類更容易受到批評。公眾反應和輿論壓力將影響判決和立法,以及個人決策。例如,人們可能會選擇一種能夠承擔事故責任和輿論壓力的駕駛系統。更糟糕的是,人們可能會改變駕駛習慣,試圖讓機器成為故障方(例如,不糾正機器的“錯誤干預”)。畢竟,如果你什么都不做,你可以讓機器來承擔這個負擔。讓我們先做一道選擇題。司機老王駕駛一輛裝有自動駕駛系統的汽車時,一名行人突然出現在路前。可怕的是剎車失靈了。如果你及時左轉,老王的車就不會撞到人;如果你一直往前開,老王的車會撞死人的。你認為老王對行人的死亡負有以下哪種責任?A、 老王決定左轉,但自動駕駛系統迫使他直行(撞人)B,老王決定直行(撞人),但自動驅動系統沒有干預C,自動駕駛系統決定左轉,而老王強迫他直行,自動駕駛系統決定直行(撞人),但老王沒有干預選項A和C,人類和機器司機都錯誤地干預了。在選項B和D中,他們都沒有進行有效干預(未進行干預)。誰更負責任?無人駕駛汽車事故的責任不是一個簡單的多項選擇題。麻省理工學院、哈佛大學、加州大學歐文分校和法國圖盧茲大學的一個聯合研究小組致力于通過定量研究了解人們對無人駕駛汽車事故的態度,并于最近發布了研究結果。作者來自許多不同的領域,如腦與認知科學、心理學、經濟學等。麻省理工學院熱門無人車課程講師Sydney Levine也是作者之一。讓我們談談麻省理工學院聯合研究小組通過三次向2583人分發問卷得出的結論:做出錯誤干預的司機是疏忽的一方,無論是人類還是機器司機;

如果人和機器同時錯過了有效的干預,公眾輿論將對機器更加寬容,人類駕駛員的疏忽也將更加受到關注。明確事故責任是無人車發展的前提。隨著無人車路試的消息傳出,我們也看到了一起事故。3月18日,優步無人車在美國亞利桑那州撞上一名行人死亡,可以理解為“干預缺失”。這起車禍的官方報告尚未公布,但據外媒報道,事故發生時,車輛已檢測到前方有行人,但決策系統“決定”不采取任何規避措施,人身安全駕駛員未能及時回應。繼優步之后,3月23日,特斯拉自動駕駛再次成為漩渦的中心:一輛開啟自動駕駛的Model X高速撞上隔離帶,導致車主不幸死亡,還導致車輛起火,兩車追尾。對此,特斯拉表示:“駕駛員已經收到了幾次警告,包括視覺警告和聲音警告。碰撞前,駕駛員沒有握住方向盤6秒鐘。事故發生前,駕駛員有大約5秒鐘的時間,視野達到150米,但車輛記錄顯示,駕駛員沒有做出任何行動。”同樣,它可以被理解為“缺失干預”。歷史總是驚人地相似。2016年5月,世界上第一起自動駕駛致命事故發生在佛羅里達州。一輛特斯拉Model S在自動駕駛模式下行駛時與一輛正在轉彎的卡車相撞,導致車主死亡。特斯拉解釋說:“在強烈的陽光條件下,司機和自動駕駛系統沒有注意到卡車的白色車身,因此制動系統沒有及時啟動。”也就是說,在這起事故中,機器司機和人類司機都應該采取措施(避免卡車左轉),但他們沒有采取行動。人類和機器司機的“疏忽干預”導致了這次撞車事故。經過六個月的調查,美國公路安全管理局等部門認定特斯拉自動駕駛系統不存在缺陷。根據世界衛生組織的統計,全球每年約有125萬人死于車禍。通常,法律裁決的重點是確定誰有過錯以及誰應對事故負責。隨著半自動駕駛和全自動駕駛技術的成熟,如何判斷誰應該公平承擔責任成為法官和陪審團面臨的難題,因為事故中的過錯和責任將由人類和機器司機共同承擔。法官和陪審團都是人。他們會偏袒自己的同胞嗎?或者你認為人類應該因為其優越的智力而承擔更多的責任?在2016年的特斯拉自動駕駛事故中,公眾顯然傾向于指責事故中疏忽大意的人類司機。例如,有傳言說主人正在看一部哈利波特電影(盡管沒有證據證實這一點)。公眾輿論對自動駕駛行業有著直接的影響。目前,公眾對混合駕駛模式引發的車禍的態度仍不明確,制造商也無法判斷其責任范圍,這直接反映在無人車定價過高,減緩了無人車的普及。如果公眾傾向于指責人類司機而不是機器,這將導致法律體系建設放緩和監管不足,也不會給制造商帶來足夠的壓力來提高無人車的安全性。麻省理工學院聯合研究小組呼吁明確事故責任,這是加強監管、促進自動駕駛行業發展的第一步。有司機的無人車有更大的責任嗎?目前,自動駕駛技術主要基于混合駕駛模式。一些自動駕駛系統可以執行超出駕駛員權限的緊急操作(例如豐田的守護天使)。其他半自動駕駛車輛可以完成大多數駕駛操作,并要求駕駛員不斷監控情況,隨時準備采取控制措施(例如特斯拉的自動駕駛儀)。在這里,核心問題是:當一輛半自動汽車發生事故并造成人員傷亡時,如何判斷人類和機器司機之間的過錯和因果責任?讓我們仔細看看麻省理工學院聯合研究小組的結論。……

hey研究了六種駕駛模式,即單駕駛模式、單駕駛模式(全自動汽車)和不同的雙駕駛組合模式(兩個人或兩臺機器)。這些模式分別對應于從L0到L5的六個級別的無人車。通常,L2豐田守護天使被歸類為H-M模式,即人類(H)是主駕駛,機器(M)是副駕駛;

L3特斯拉自動駕駛儀被歸類為M-H模式,即機器是主駕駛,人類是副駕駛。重點是H-M和M-H模式下的兩個場景:主駕駛做出了正確的判斷,副駕駛做出了錯誤的判斷(“錯誤干預”),而副駕駛沒有干預(“錯過干預”)。研究人員使用兩個自變量進行回歸:駕駛員是否犯了錯誤和駕駛員類型(人或機器)。在“錯誤干預”場景中,最重要的發現是駕駛員是否犯錯對分數有顯著影響,但駕駛員類型對結果沒有明顯影響。從下圖左側可以看出,做出錯誤干預的副駕駛被認為是更疏忽的,當副駕駛是藍色(機器)或紅色(人類)時,疏忽和責任的得分接近。換句話說,人們普遍認為,做出錯誤判斷的一方是疏忽大意的一方。如果“錯誤干預”駕駛操作導致行人死亡,那么無論是人還是機器做出誤判,都應該承擔更多責任。

不同駕駛模式的故障和責任評估分數(分數越高,責任越大)。藍色代表車輛本身和汽車制造商的疊加責任分數,紅色代表人類駕駛員的責任分數。x軸標簽第一個駕駛員指主駕駛員,最后一個駕駛員指副駕駛員。然而,“缺失干預”的研究結果與以往的研究結果有所不同。先前的研究表明,當機器和人類都做出錯誤的判斷時,機器會受到更多的指責。此外,當人和算法犯同樣的錯誤時,人們對算法失去信任的速度比人類自己更快。這次的結論是,如果出現“遺漏干預”的情況(即人為錯誤機器不干預,或者人為錯誤機器沒有干預),機器的責任程度顯然低于人類。在雙司機模式下,人類和機器司機都要承擔責任(缺乏有效干預),但紅藍之間的差距顯而易見。相比之下,如果主駕駛和副駕駛都是人或機器,那么他們的責任分數是相同的(對應于上圖右側的第2行和第7行)。具體的回歸結果如圖所示:

他們本應該采取行動,但他們什么也沒做。盡管人們對無人駕駛汽車的普及可能有許多心理障礙,但這一結果表明,在混合駕駛模式下,公眾不會對事故反應過度。盡管在研究中進行了一些系統的簡化,但研究結果也能反映一些公眾言論的效果。公眾傾向于關注人類司機的極端疏忽,因此他們指責人類司機而不是機器。受訪者還分別對人類和機器駕駛員的能力進行了評估,結果相似。在得知這起事故之前,受訪者對人類和機器的駕駛能力有著同樣的信心。在被告知發生了“錯過干預”的事故后,信心也以同樣的比例下降。

事實上,我們應該更加關注公眾的反應不足。研究人員認為,缺乏公眾回應將導致公眾缺乏推動監管法案制定的壓力。如果半自動駕駛汽車的監管法案在有陪審團的法院頒布,陪審團的裁決將偏向汽車制造商,從而在人機共同錯誤的情況下免除其責任。在這種情況下,不可能向制造商施加足夠的壓力來提高汽車的安全性能設計。事實上,我們以前也經歷過類似的情況。在20世紀60年代之前,汽車制造商將事故歸咎于駕駛員的錯誤或疏忽,從而僥幸逃脫。因此,有必要通過自上而下的監督將“事故責任制”的概念引入法律體系,即汽車設計應最大限度地減少事故發生時對乘客造成的傷害。只有在法律的約束下……

汽車制造商可能被迫改進他們的設計。然而,安全標準仍然是一個懸而未決的問題。研究人員指出,只有在一種情況下,公眾可能反應過度,機器將比人類受到更多的指責:機器做出了“錯誤的干預”。在這種駕駛模式下,人類沒有義務糾正機器犯下的錯誤。換句話說,機器的工作是糾正人類可能犯的錯誤,但如果機器犯了錯誤,人類就沒有義務糾正。(僅在“H-M”模式下。在“M-H”模式下,當機器發生故障時,糾正故障始終是人類的責任。因此,一旦“錯誤干預”導致事故如果發生這種情況,可能會引起公眾的廣泛關注。如果我們不能正確預測和管理這一點,全自動駕駛技術的進程可能會放緩。在開發比人類更有權威的汽車時,制造商應該注意這種極端情況,因為在這種情況下,機器比人類更容易受到批評。公眾反應和輿論壓力將影響判決和立法,以及個人決策。例如,人們可能會選擇一種能夠承擔事故責任和輿論壓力的駕駛系統。更糟糕的是,人們可能會改變駕駛習慣,試圖讓機器成為故障方(例如,不糾正機器的“錯誤干預”)。畢竟,如果你什么都不做,你可以讓機器來承擔這個負擔。

二手車行業一向以廣告營銷戰、融資戰著稱。進入2018年,二手車行業依然不平靜。

1900/1/1 0:00:00不可否認,在最近一些年里,汽車圈里玩的熱點之一那就是“跨界”不論是造火箭的SpaceX,還是搞搜索引擎Google或者是賣手機的蘋果,都卷入了轟轟烈烈的造車運動。

1900/1/1 0:00:00在造車新勢力或剛剛走下PPT或奮戰于量產車生產的時候,一直沒有什么新聞,在新造車企業中“低調”的電咖汽車卻突然宣布率先交出了第一份銷量成績單。

1900/1/1 0:00:00為期三天的谷歌IO開發者大會于5月8日在美國開幕。在主題演講上,CEOSundarPichai和各產品線負責人講解了自家的AI、安卓系統、谷歌助手等產品的進展。

1900/1/1 0:00:00彭博近日刊文指出,包括中國在內的亞洲各國政府,在無人駕駛技術方面推出大量支持政策,讓百度Apollo這樣由企業主導的無人駕駛平臺獲得巨大發展。

1900/1/1 0:00:005月17日,工信部發布了第308批《道路機動車輛生產企業及產品公告》,其中,浙江合眾新能源汽車有限公司進入擬發布新增車輛生產企業清單。

1900/1/1 0:00:00